Задача проекта — решить практическую проблему изолированности LLM-моделей от актуальной информации.

Стандартная модель ограничена данными на момент обучения и не имеет управляемого доступа к внешним источникам. Проект направлен на создание backend-сервиса, который позволяет получать релевантную информацию из сети, контролировать процесс поиска и извлечения данных и передавать в модель уже подготовленный контекст.

Решение ориентировано на прикладное использование: стабильность, предсказуемость поведения и возможность адаптации под конкретные требования системы.

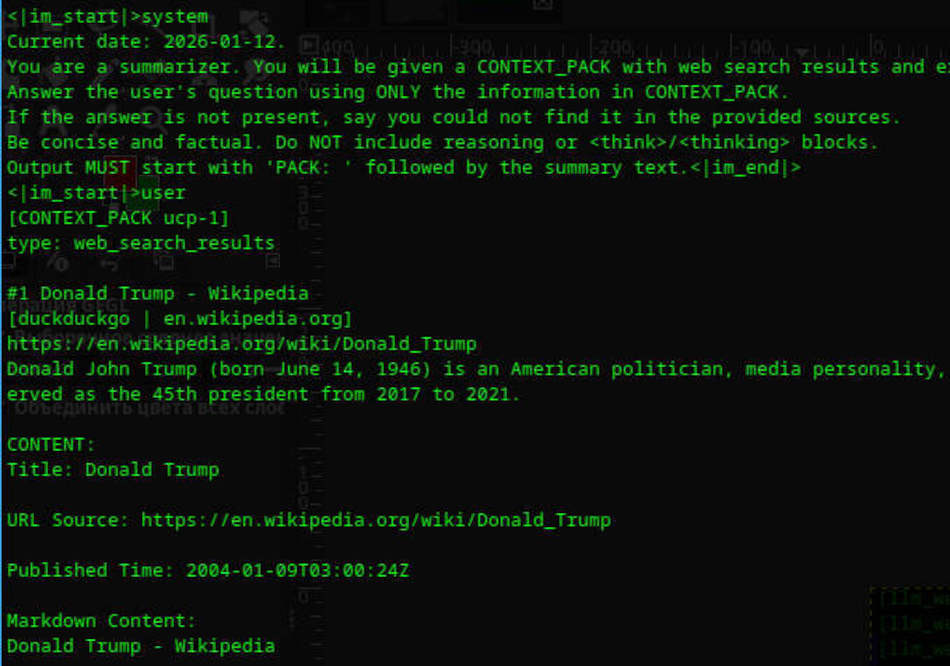

Разработан самостоятельный backend-сервис на Node.js с многошаговым pipeline обработки данных.

Реализованы:

— управляемый веб-поиск по запросу модели

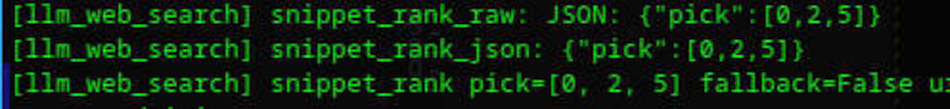

— отбор и ограничение количества источников

— загрузка страниц и извлечение текстового содержимого

— очистка и нормализация данных

— предсказуемый формат передачи контекста в LLM

Сервис интегрирован с Text Generation WebUI и может использоваться как внешний модуль в других системах. Архитектура ориентирована на расширяемость, отладку и контроль каждого этапа обработки данных.

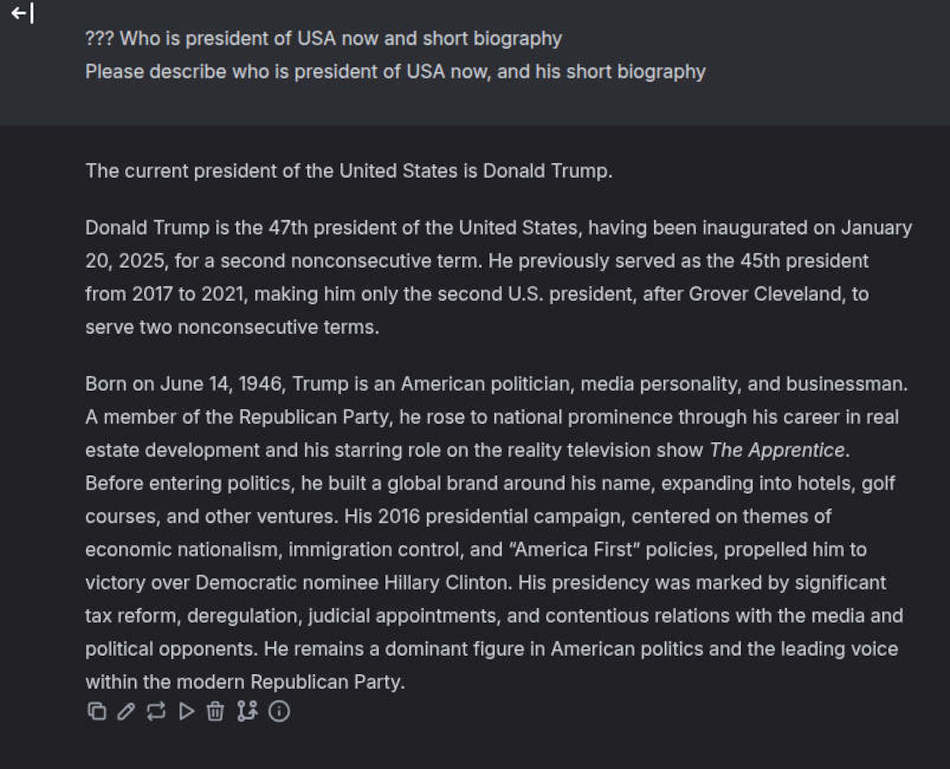

LLM перестаёт быть изолированной от внешнего мира и получает доступ к актуальной информации из сети в управляемом и контролируемом виде.

Модель может:

— находить свежие данные, документацию и новости

— работать с источниками вне своего обучающего корпуса

— получать структурированный и очищенный контекст вместо «сырых» данных

В результате повышается практическая применимость LLM в реальных задачах: от аналитики и справочных систем до внутренних помощников и автоматизации рабочих процессов.