Благовещенск (Амурская обл.)

На сайте с: 18.09.2025

Превращаю слова в золото

Дмитрий Шипицын samseberul

Верифицирован через Сбер ID

Материалы про MCP-серверы, GPU-инфраструктуру и новое железо под AI стабильно вызывают интерес, особенно с графиками и кейсами.

Что показать:

– Разницу между CPU и GPU серверами;

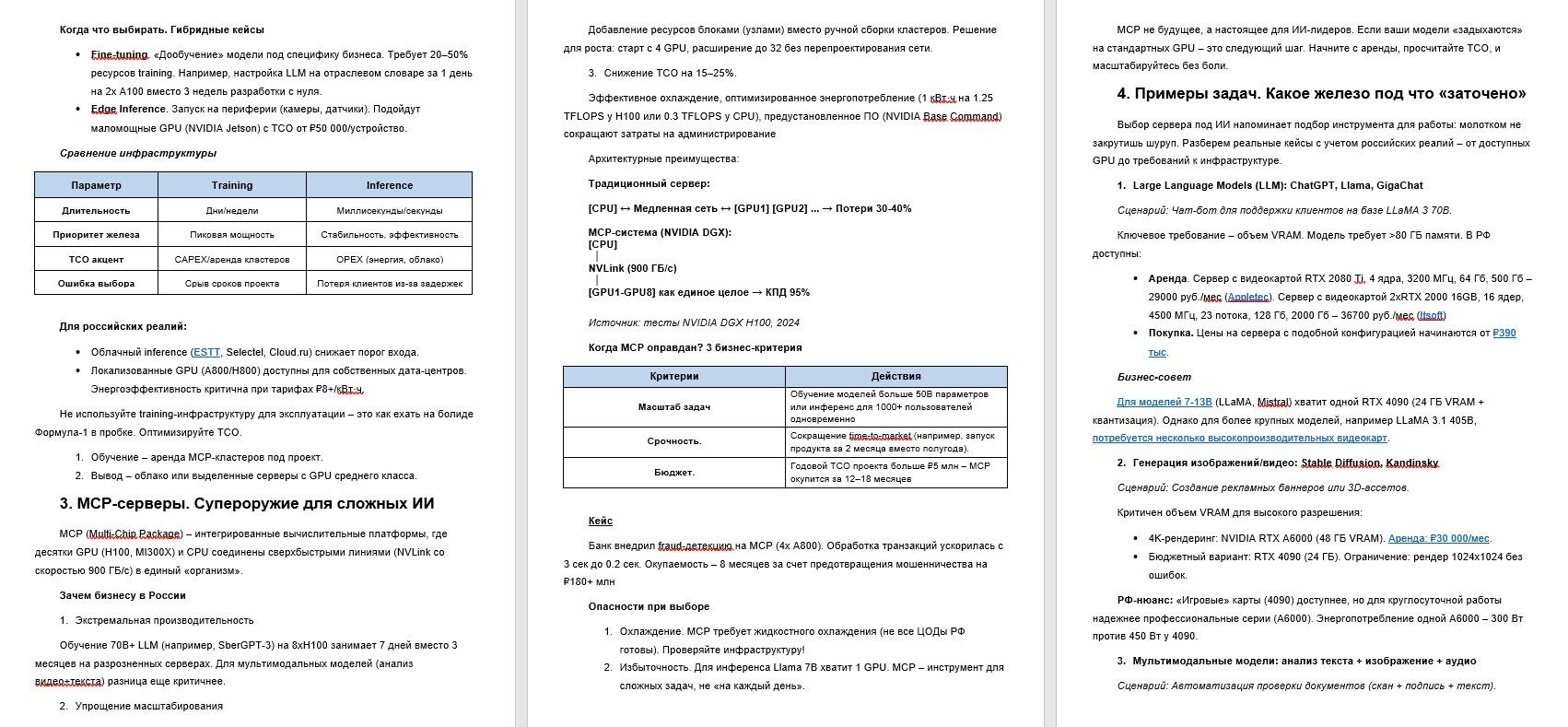

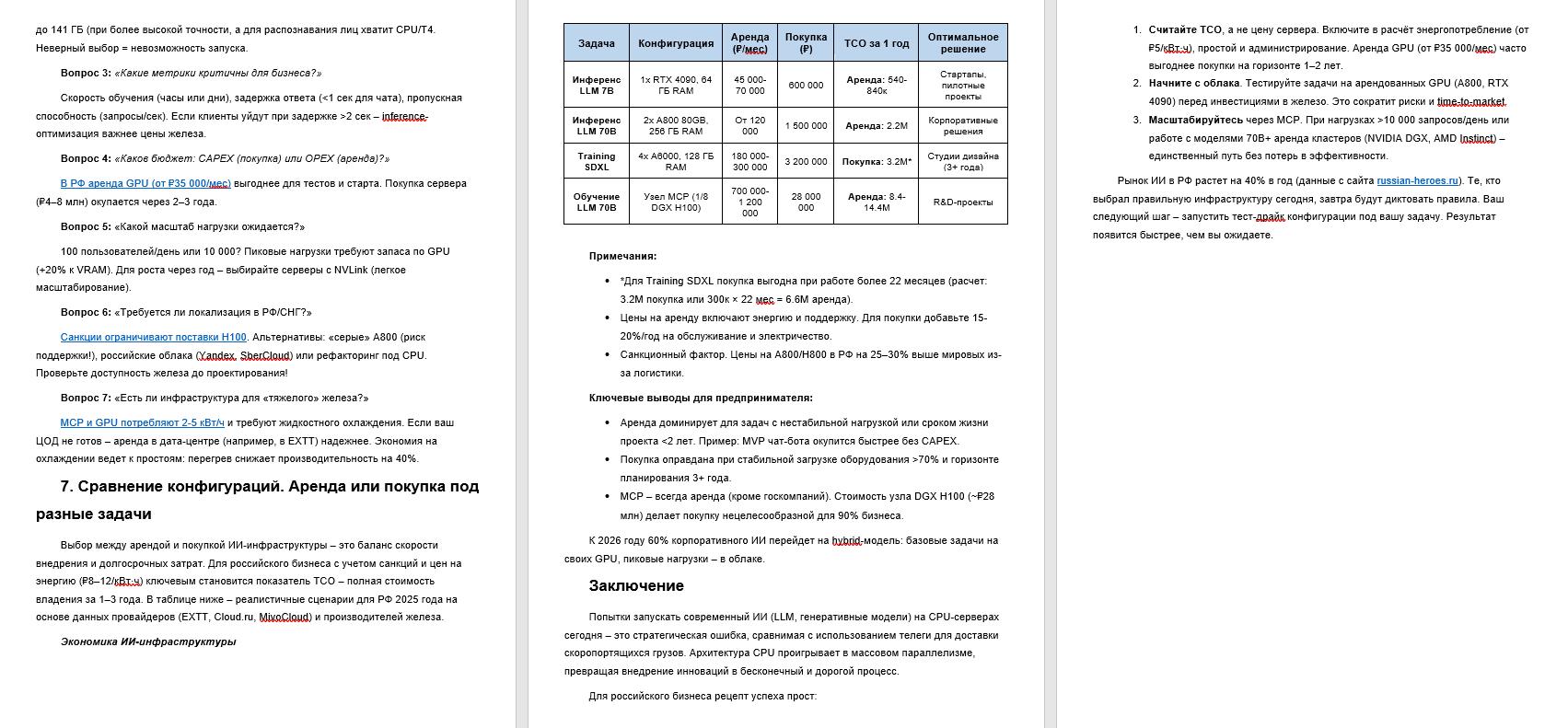

– Требования inference vs training;

– Пояснение, что такое MCP-серверы;

– Примеры задач: LLM, генерация, мультимодальные модели;

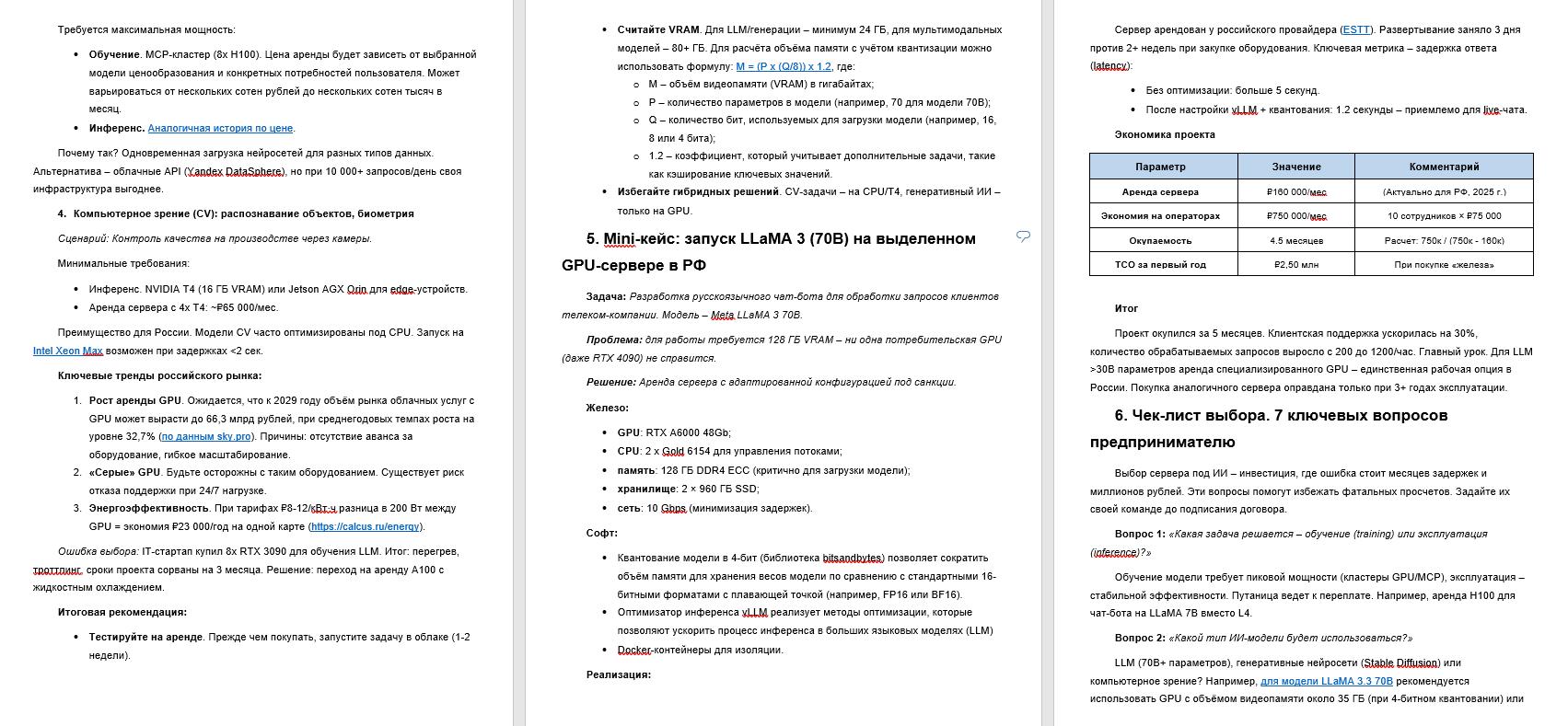

– Mini-кейс: запуск LLaMA 3 на выделенном сервере.

Формат: статья с мини чек-листом + сравнение конфигураций.

Анализ темы

Создание структуры с одновременным сбором информации при помощи нейросети.

Написание статьи.

Редактирование.