Vyacheslav Simdyanov vyacheslav742

Разработаю парсер под конкретный сайт в виде Desktop приложения

12 000 руб

сделаю за 7 дней

Разработаю парсер под конкретный сайт в виде Desktop-приложения (Python, PyQt):

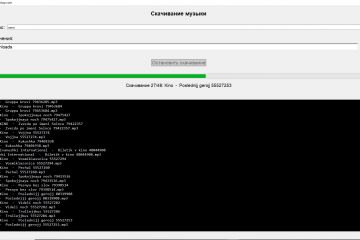

Бекенд-ядро на Python: Использую Scrapy, aiohttp, Selenium или BeautifulSoup для парсинга любой сложности, включая JS-рендеринг.

Frontend на PyQt6: Нативное, быстрое и красивое оконное приложение под Windows/Linux/macOS. Не Electron с гигабайтами памяти, а легкий и отзывчивый интерфейс.

Результат — автономный бинарник: Вы сможете запустить приложение без установки Python и знания командной строки.

Что получите в итоге:

исполняемый файл с инсталлятором

Окно с настройками (прокси, тайминги, глубина парсинга)

Встроенный планировщик задач

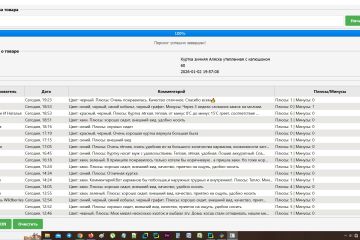

Просмотр результатов в табличном виде с сортировкой

Экспорт в CSV, Excel, JSON одной кнопкой.

От вас:

Целевой сайт (URL): Основная страница, от которой будем «плясать». Если сайтов несколько — список.

Что конкретно нужно собирать? Будьте максимально детальны.

Пример: «Название товара, артикул, цену (основную и со скидкой), наличие (в наличии/под заказ), ссылку на картинку, характеристики в виде списка».

Куда и в каком виде выводить результат?

Формат: Excel (XLSX), CSV, JSON, SQLite-база рядом с программой.

Структура: Нужны ли отдельные листы, как назвать столбцы, нужна ли группировка?